Google glass ; prise en main et perspectives ophtalmologiques

A la découverte des Google glass…

L’histoire retiendra-t-elle l’année 2012, qui a vu la mise au point des Google glass, comme la date de la véritable invention des lunettes? L’innovation transforme à ce point leur usage qu’elle pourrait bien faire oublier qu’avant d’augmenter la vision, elles ont plus modestement servi, pendant près de sept siècles, à simplement la corriger. Si les lunettes connectées ne font pas encore partie de notre quotidien, elles pourraient devenir dans un avenir proche un accessoire indispensable de ce qu’il est désormais convenu de nommer l’homo connectus : au-delà de la fascination qu’elles suscitent dans les cercles les plus technophiles, il suffit d’aborder la question dans une conversation pour mesurer l’étendue de l’intérêt qu’elles éveillent chez un très large public.

Le principe en est simple : grâce à une source optique placée à quelques millimètres de distance de l’oeil, sur la branche droite de la monture, et reliée à internet par l’intermédiaire d’un smartphone, l’information de la toile vient s’intégrer en surimpression à son champ de vision. Les informations visuelles fournies par ces lunettes intelligentes sont encore rudimentaires, ne serait-ce que parce que l’affichage proposé ne s’étend que sur une portion restreinte et périphérique du champ visuel.

Il n’en reste pas moins que, en superposant une image numérique à l’image organique perçue par l’oeil, elles confrontent pour la première fois leur utilisateur à une dualité perceptive immédiate.

Ni réponse au vieux fantasme de super-vision, ni promesse d’absorption de leur utilisateur dans une réalité parallèle, les Google glass estompent ainsi concrètement la frontière entre les mondes physique et virtuel et esquissent les contours d’une nouvelle réalité visuelle qui pourrait être à loisir augmentée, façonnée, substituée.

Cette page a pour objet de relater mon premier contact vis à vis de ces Google glass que j’ai pu tester récemment, et de passer en revue leurs principales applications potentielles, notamment dans le monde médical et plus particulièrement en ophtalmologie.

Prise en main des Google glass

Avant de décrire plus en détail les caractéristiques techniques de ces Google glass, il me semble plus intéressant de partager les premières impressions ressenties lors de leur prise en main. L’aspect général est plutôt flatteur, on n’a pas le sentiment de saisir un prototype, mais un produit (bien) fini. La monture en titanium est assez fine, et le bloc lunette, sans être discret, ne m’a pas paru très protubérant.

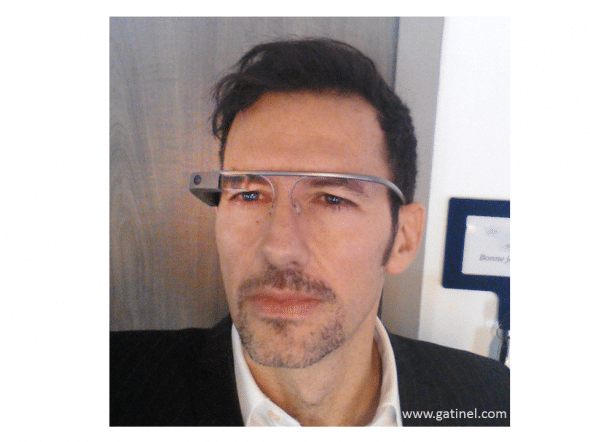

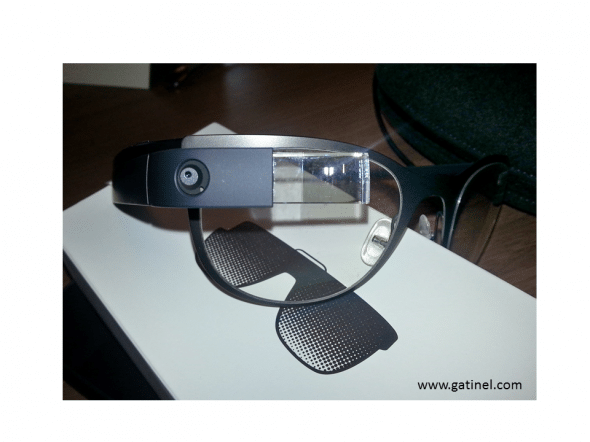

Présentation des Google glass; le bloc opto-électronique est situé sur la branche droite d’une fine monture en titanium.

Sur l’exemplaire essayé, il n’y avait pas de verres de prescription, et une fois posé sur le nez et les oreilles, aucune distorsion ou déformation de la vision n’était notable. Le système d’affichage est situé nettement au dessus de l’œil droit, ce qui explique vraisemblablement l’absence de gêne véritable. La marche, les mouvements naturels de la tête ne provoquent aucune difficulté particulière.

Aspect du « porté » des Google glass, mélange plutôt réussi de lignes classiques et futuristes, sans exubérance et relativement discret.

Malgré l’asymétrie du dispositif (« le bloc » électronique est porté sur la branche droite de la monture), le poids de l’équipement semble négligeable (moins de 40 grammes sur la balance!). Éteintes, les lunettes se feraient presque oublier, même si l’on perçoit comme une ombre le système de visualisation dans la partie supéro-externe du champ de vision de l’œil droit.

Une pression prolongée sur le bouton « power » provoque l’allumage des lunettes et du système de visualisation, qui s’illumine comme un écran digital rectangulaire dont il est difficile de donner un ratio. Il paraît comme un écran de 15 pouces qui serait observé à environ 1.50 mètre (ou bien un 46 pouces observé à 5 mètres: l’écran paraît relativement « loin » de l’oeil). Su fait de la disposition du système d’affichage, l’image n’apparaît pas au centre du champ de la vision, et de fait ne provoque pas de sentiment de gêne ou d’obstruction : il est nécessaire de déplacer son regard en haut et à droite pour la lire.

Ayant déjà été confronté à des systèmes d’affichage « tête haute » (il en existe dans certains lasers excimers comme l’EX500 de Wavelight), ainsi que l’utilisation de casques vidéo, le fait de « voir » une image ou un texte projetés ou flottants dans mon champ de vision ne m’a certainement pas autant surpris que si j’avais été totalement novice en la matière. Mais cela demeure sans aucun doute une expérience surprenante, que d’aucun pourront qualifier de « magique » lors de leur première confrontation avec cette lucarne virtuelle. La persistance de l’image et son suivi naturel avec les mouvements de la tête, la possibilité de la décaler dans son champ de vision (on peut basculer délicatement avec les doigts le système de visualisation de manière à placer l’écran en vision centrale si on ne souhaite pas le laisser à la périphérie supérieure du champ de vision) sont autant d’éléments qui ont participé à rendre cette première expérience agréable, voire addictive. Mon œil droit étant directeur, la sensation d’ « immersion » dans l’image projetée était assez bluffante. Le contraste de cet affichage est de bonne qualité, sa luminosité est plutôt douce et confortable. On ne perçoit aucune « pixellisation », malgré la (relativement) faible résolution native; qui est de 640 x 360. On peut représenter cette densité comme celle qui occuperait environ 1/9e de la surface totale d’un écran 1920×1080. Un calcul fondé sur un angle apparent de 12° pour la verticale de cet écran virtuel permet d’établir que cette résolution est à même d’éviter la perception de la trame des pixels pour un oeil disposant d’une acuité visuelle de 10/10 (voir la page consacrée à l’acuité visuelle et des exemples concrets). Il n’est pas besoin d’accommoder pour lire cet affichage, qui apparaîtra donc net à un emmétrope (sujet n’ayant pas besoin de lunettes pour bien voir de loin) même devenu presbyte.

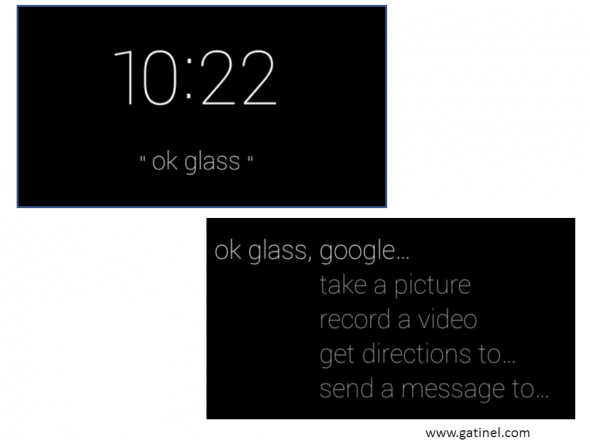

L’écran d’accueil des Google glass est constitué de l’affichage numérique de l’heure et de l’inscription « ok glass », dont l’énonciation à voix haute permet d’accéder au premier menu de fonctions (« take a picture », « send a message », etc).

L’affichage s’effectue par défaut en caractères blancs sur fond noir, solution certainement plus économe en énergie, et plus reposante visuellement, même si l’on perçoit un léger halo de couleur violette. En faisant défiler les images stockées dans la timeline, on s’aperçoit qu’elles sont pour la plupart discernables avec un bon rendu, quel que soit le fond de la scène sur laquelle elles apparaissent. Il faut privilégier les surfaces sombres et homogènes pour une visualisation optimale, et éviter l’impression d’une légère désaturation des couleurs.

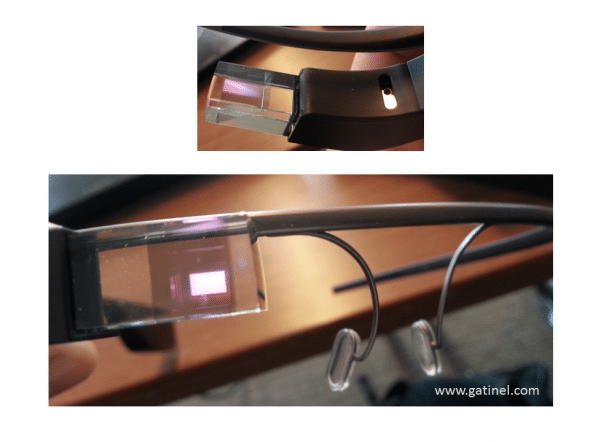

Ce cliché permet de se faire une petite idée de la qualité de l’affichage luminescent, qui se superpose à celui du « fond » (ici le revêtement du faux plafond)

Sur la paire de lunettes essayée, l’affichage disparaissait au bout d’un certain temps d’inutilisation, mais un hochement de tête suffisait à le réactiver. Le son est transmis par conduction osseuse (il n’y a pas d’écouteur), ce qui évite à son voisin d’entendre ce que les lunettes racontent, mais nécessite un environnement sonore relativement calme.

Au final, on s’habitue assez vite à cet affichage virtuel, qui loin d’une intrusion visuelle m’est apparu rapidement semblable à une sorte de « widget » naturel, flottant dans mon champ de vision, et contribuant à estomper la frontière entre l’image réelle et virtuelle sans que cette fusion soit véritablement conflictuelle. Le défilement des images et fenêtres situées dans la timeline s’effectue de manière assez fluide, en effleurant le trackpad (bord externe des lunettes).

Il n’est pas possible actuellement de naviguer directement sur la plupart des sites web avec un bon affichage, que ce soit en Wifi (en direct depuis les lunettes), ou par l’intermédiaire de la connexion 3Gou 4G de son Smartphone (connexion bluetooth), mais il est déjà possible d’utiliser des applications dédiées (Google hangouts, application pour les glass du New York Time) ou des « passerelles » visant à formater et pousser du contenu pour être affiché par les GG. Je n’ai pas essayé de saisir du texte oralement, mais ceci semble pour l’instant une tâche ardue, à moins que le système de reconnaissance vocale soit particulièrement performant, ou que Google développe une application de type clavier déporté, ou un système astucieux mettant à contribution le Smartphone relié. Pour rentrer un code wifi, il existe par exemple une application ingénieuse qui transforme le texte saisi sur un Smartphone en un QRcode, qu’il suffit ensuite de « flasher » avec les Google glass.

L’autonomie est annoncée pour une journée, mais l’utilisation intensive de la vidéo ou la géo-localisation la réduit fortement, selon les utilisateurs pionniers. Il est toutefois possible de relier les GG à une batterie externe, comme celles qui permettent de recharger les Smartphones (prise micro USB). Les Google glass à tendance à chauffer au bout de quelques minutes d’utilisation intense.

Google glass : présentation technique

Petit historique

La première référence officielle au « projet lunettes » (Project Glass) a été faite par Google le 4 Avril 2012. Depuis, ce qui semble toujours de l’ordre du projet (puisque aucune commercialisation grand public n’a encore été faite, même aux USA) a toutefois franchi plusieurs étapes importantes, dont la mise à disposition pour certains utilisateurs et développeurs principalement américains d’exemplaires -payants, autour de 1500 USD- de ces fameuses lunettes en avril 2013. Un partenariat avec le fabricant de monture Luxottica (Ray-Ban, Oakley, Persol,…) a été signé en mars 2014, ce qui placerait a priori une part importante de la distribution de la future version commerciale des GG du côté des opticiens, au moins pour les versions devant équiper des lunettes de prescription (myopie, etc.) ou des équipements optiques sportifs ou solaires. Cette stratégie commerciale a été initiée récemment en Californie et dans l’état de l’Illinois.

Une version adaptable sur lunettes de vue est d’ores et déjà disponible ; il suffit pour l’adapter qu’une branche de la monture dispose d’un pas de vis spécialement conçu pour y visser le bloc GG.

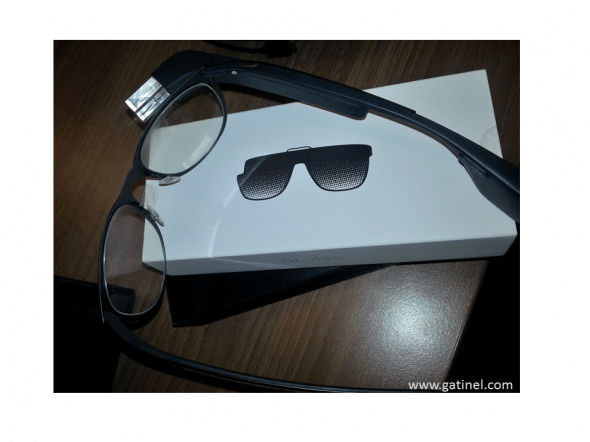

Le bloc « Google glass », fixé ici sur une monture traditionnelle pouvant être équipée de verres correcteurs ou solaires.

Que contiennent ces Google glass ?

Les lunettes intelligentes de Google ne correspondent pas tant à des lunettes proprement dites (équipement classique associant une monture et une pire de verres) – qu’à un bloc comprenant un module opto-électronique formés de divers éléments. Ces composants sont rassemblés dans une coque plastique oblongue, dont l’extrémité avant comporte un élément optique transparent au travers duquel on pourra observer l’image projetée par les lunettes.

La monture en titanium ne comporte pas d’emplacement destiné à recevoir des verres de vues (« prescription glasses » en anglais), mais il est possible d’y clipper des verres transparents (protection) ou des filtres solaires (ces verres sont fournis avec les lunettes).

Les éléments assemblés dans le bloc lunettes comprennent : un processeur, une mémoire flash16 GB SanDisk – dont 12 GB pour l’utilisateur, un micro audio, d’une caméra, un touchpad, un microsystème d’affichage (display) de résolution 640×360 assorti à un groupe d’éléments optiques comprenant un « prisme » permettant la projection de l’image virtuelle, un emetteur audio(conduction osseuse), un micro audio, d’une batterie Lithium Polymer (située dans le renflement de l’extrémité de la branche).

L’image rectangulaire « projetée » par les Google glass est formée par les 230 000 pixels du micro système d’affichage. La batterie peut être rechargée par sur secteur (chargeur et câble micro USB).

Le système d’exploitation actuel est Android ICS 4.0.4. et les lunettes communiquent en Wifi 802.11b/g et Bluetooth. Les autres technologies embarquées associent un gyroscope, un accéléromètre, un compas, un capteur de proximité, un capteur de lumière ambiante, un capteur infrarouge.

En parallèle à cet objet matériel, les Google glass correspondent à une nouvelle plateforme de développement, et constituent le cœur d’un nouvel écosystème pour des applications mettant à profit leur principaux atouts : la projection d’une image « virtuelle » dans le champ de vision de l’œil droit du porteur, et la possibilité de saisie d’images et de vidéo en utilisation « mains libres ».

Les mises à jour du système d’exploitation sont automatiques et permettent à certaines fonctions d’ajoutées, alors que d’autres sont supprimées (ex: la reconnaissance faciale)

Google glass et correction en lunettes de vue

Actuellement, les lunettes de Google semblent conçues pour être utilisées à droite, même s’il n’est pas exclu qu’elles soient également disponibles en version « œil gauche » lors de leur commercialisation). Comme souligné précédemment, l’adaptation aux lunettes de vue est d’ores et déjà prévue, et il semble de fait que les boutiques d’optique visuelle et les réseaux de distributeurs joueront un rôle prééminent dans la commercialisation des Google glass. A priori, l’interposition d’un verre correcteur entre l’œil et le système de visualisation ne devrait pas poser de problème majeur, à condition que la puissance du verre ne soit pas excessive (ex: -4 à + 4 Dioptries).

Contrôle des Google glass

Le contrôle des Google glass s’effectue par la voix ou par le toucher (grâce au track pad). L’activation vocale des lunettes s’effectue par la prononciation à voix haute « OK, Glass ». A y réfléchir, l’utilisation de la commande vocale pour l’activation d’un dispositif tel que les Google glass est assez innovant. Pour prendre une photo, il suffit de prononcer la phrase « Take a picture » (en anglais). Prendre une photo à la voix n’est pas si évident, tant le « doigt » semble être l’organe auquel est associé ce geste.

Le bouton Power (qu’il faut presser au moins 3 secondes) permet d’allumer et d’éteindre les GG. Le trackpad (surface externe) permet de faire défiler les éléments de la timeline. Un bouton spécifique commande la prise de photos/vidéos. La caméra n’est pas coaxiale avec l’œil, et l’angle de la prise de vue est plutôt large. Il ne m’a pas paru possible d’effectuer un « zoom » ou un cliché macro avec l’équipement testé. En raison de la petitesse du capteur et de l’optique du système de caméra, la profondeur de champ est élevée et l’image apparait nette dans son ensemble.

Fonctions basiques

Les fonctions basiques offertes par ces lunettes sont :

– la prise de photos (5 Mégapixels) et de vidéo (720p) grâce à la caméra intégrée : ces données pouvant ensuite être partagées par l’envoi d’email ou sur les réseaux sociaux. Il est aussi possible de participer à une téléconférence (hangout), appeler des contacts, etc.

– recevoir des notifications email, Google plus

– faire une recherche Google

– une fonction GPS où l’on peut demander des directions

– un support audio (AAC et MP3)

– l’affichage de vignettes sur l’écran virtuel, avec une « Timeline » qui comporte tout ce qui a été fait et reçu.

Quand les lunettes s’allument, le système Android permet à l’heure de s’afficher sur un fond d’écran noir, soulignée de l’inscription « ok glass ». En effleurant le trackpad, on peut afficher des inscriptions météorologiques (température, taux d’humidité, etc.).

La visualisation de l’écran virtuel repose sur un ingénieux et relativement simple (en apparence) système optique, qui permet de part sa transparence de ne pas obstruer la vision et présenter à l’oeil l’mage virtuelle de l’écran d’affichage, qui est situé dans le bloc fixé à la monture.

Une fois qu’elles sont allumées, il est possible d’inspecter les Google glass et saisir l’image en réflexion de l’écran d’affichage, dont l’angle apparent augmente notablement une fois la monture chaussée.

Fonctions installables, applications

Les diffuseurs de contenu numérique, les sociétés déjà présentes sur l’internet et les fournisseurs d’applications Smartphone, développent déjà des applications spécifiques pour les GG, qui seront prêtes et disponibles dès l’ouverture d’un futur « Glass store » une fois l’étape de commercialisation des lunettes franchie. Google a asservi à ses lunettes certaines de ses applications comme Now, Hangouts, Maps, etc.

Ainsi, le catalogue d’applications Google glass est déjà bien fourni, même si le nombre actuellement disponible d’applications dédiées est infime en comparaison avec ce que l’on peut trouver sur Google Play pour les smartphones et tablettes sous Android : le New York Times, CNN, la version américaine du magazine Elles disposent par exemple d’une application spécifique, et diffusent du contenu (texte, images, petites vidéos), et une kyrielle de petits programmes complémentaires est déjà disponible en téléchargement.

Perspectives

Les Google glass semblent l’objet idéal pour rassasier l’appétit visuel des internautes toujours plus avides d’images et de vidéos. La suppression apparente d’un support physique palpable (écran) rapproche l’image de l’œil et suggère comme une possibilité d’engloutir plus facilement cette surabondance d’offre digitale.

Même s’il est possible de filmer avec un simple caméscope ou un Smartphone, la saisie d’images et vidéos avec les mains libres offre a priori aux spectateurs la possibilité d’assister à une retransmission plus fidèle, proche de la vision subjective du réalisateur équipé des lunettes. On pense naturellement ici à l’enseignement de la chirurgie, mais des activités plus courantes comme la retransmission d’un cours de cuisine ou de bricolage pourraient aussi en bénéficier.

La fonction d’affichage des images sur écran est également un atout pour l’utilisateur : quel orateur ne rêverait pas de disposer d’un prompteur invisible ? Quel coureur ne serait pas intéressé de pouvoir consulter à chaque instant des informations relatives à la distance parcourue, le nombre de calories brûlées, sa position sur une carte (GPS) ainsi que celle de ses challengers ? Plus anecdotique, mais symptomatique du caractère exclusif que revêtent actuellement ces lunettes, il existe déjà une application permettant aux possesseurs du bolide électrique Tesla de commander l’ouverture des portes ou contrôler le niveau de charge de la batterie… grâce aux Google glass.

Si la plupart des applications disponibles sur les Smartphones Android semblent pouvoir être utilisées sur les GG au prix d’un affichage adapté à ce nouveau support, celles qui tireront pleinement parti d’une utilisation « main libre » seront a priori les plus intéressantes. La transmission d’images ou de vidéos « en vision subjective, proches de celles captées par l’œil du porteur de ces lunettes offre des perspectives intéressantes pour le reportage, l’éducation, voire toutes les situations ou la transmission d’images joue un rôle central (enseignement, télémédecine…). Une banale opération du genou fut un buzz notable grâce aux Google glass qui équipaient le Dr Christopher Kaeding de l’Université de l’Ohio (OSU) à l’été 2013 ; elle fut la première chirurgie retransmise en « live » grâce à celles-ci.

Pour le chirurgien, la possibilité de pouvoir visualiser et faire défiler des documents utiles à la bonne gestion de l’opération est à même de sécuriser et d’augmenter la qualité de l’acte opératoire. Visualiser confortablement et sans l’utilisation d’un support annexe plus encombrant de l’iconographie (schéma, coupes scanner, radiographies) et du texte (rapport d’observations, mentions spéciales) semble un atout évident. Les données affichées pouvant être restreintes au seul porteur des lunettes, elles garantissent le respect de la confidentialité de données sensibles.

Ces caractéristiques suggèrent qu’il sera difficile de prédire l’impact sociologique de ces nouveaux moyens d’observation et de communication. Créeront- ils une nouvelle forme de solidarité sociale entre porteurs de lunettes connectées qui seront mises au service de leur frénésie de partage, ou les isoleront-ils au contraire un peu plus derrière un nouvel écran invisible ?

La possibilité de filmer « à l’insu » de son interlocuteur, d’enregistrer et archiver des images soulève quelques inquiétudes, auxquelles s’ajoutent d’autres questions éthiques comme celle de la reconnaissance faciale. On se souvient des problèmes soulevés par l’application Google « Street view », dont certaines images avaient été jugées intrusives… La commercialisation et la mise à disposition des GG auprès des consommateurs verra sans aucun doute naitre pléthore d’utilisations originale, de services nouveaux, mais aussi de litiges, et peut être de restrictions d’usage. On pense bien entendu à la conduite automobile, même si les GG pourraient s’allier à la sécurité routière, en prodiguant des conseils d’itinéraires et de conduite apaisée, voire en « réveillant » un conducteur au moindre signe d’assoupissement (application DriveSafe4Glass).

Conclusion

En injectant directement entre l’œil et l’objet du regard une image numérique destinée à « augmenter la réalité », les Google Glass proposent aussi d’augmenter la définition même de la fonction de vision. Il est permis de s’interroger sur les conséquences d’un tel basculement de notre perception du monde environnant.

Les Google glass semblent à la fois pratiques, innovantes, elles symbolisent les liens de plus en plus étroits que tissent avec nos fonctions sensorielles les progrès technologiques pour plus de communication et d’échange d’informations. Mais elles intriguent aussi, et soulèvent quelques interrogations quant à l’usage des données qu’elles pourront collecter d’une manière aussi efficace que discrète.

Pour un ophtalmologiste, cet objet est doublement fascinant ; les Google glass paraissent à la fois comme une extension de l’œil, un support visuel, un vecteur innovant pour l’enseignement audiovisuel de la spécialité, mais aussi une aide potentielle à la vision pour certains patients. Des lunettes électroniques munies de capteurs optiques et couplées à des prothèses de rétine artificielles sont déjà testées depuis plusieurs années dans des laboratoires de recherches pour des sujets malvoyants. Les Google glass offrent quant à elles un nouveau paradigme car elles sont les premières lunettes qui, paradoxalement, s’adressent en majorité aux « bien voyants ». Néanmoins, des applications à visée thérapeutiques ou destinées à suppléer à certaines déficiences visuelles seront probablement développées en Ophtalmologie.

L’essor des lunettes de vue fut contemporain et nourri de l’invention de l’imprimerie. L’internet n’étant finalement qu’une sorte de prolongement numérique de ce moyen de support et de diffusion d’information, le passage de simples binocles aux modernes Google glass relève peut-être moins d’une réelle innovation que d’une évolution inéluctable.

Laisser un commentaire